世界末日钟——象征着人类距离自我毁灭有多近的象征性仲裁者——现在显示为距离午夜89秒,比以往任何时候都更接近发出我们物种无回头路的信号。

许多威胁,包括气候变化和生物武器,促使伊利诺伊州芝加哥的《原子科学家公报》的全球安全专家在1月份移动了时钟的指针。但这些危险中最大的是日益增长且经常被忽视的核战争风险。

“我们不断听到的信息是,核风险已经过去,那是冷战时期的老风险,”芝加哥大学物理学家、末日时钟决策顾问丹尼尔·霍尔兹说。“但是当你和专家交谈时,你得到的信息正好相反——实际上核风险非常高,并且在增加。”

从俄罗斯在乌克兰的持久战争、五月印度和巴基斯坦之间的紧张局势爆发,到六月美国和以色列对伊朗核设施的袭击,世界上不缺乏涉及一个或多个核武器国家的冲突。

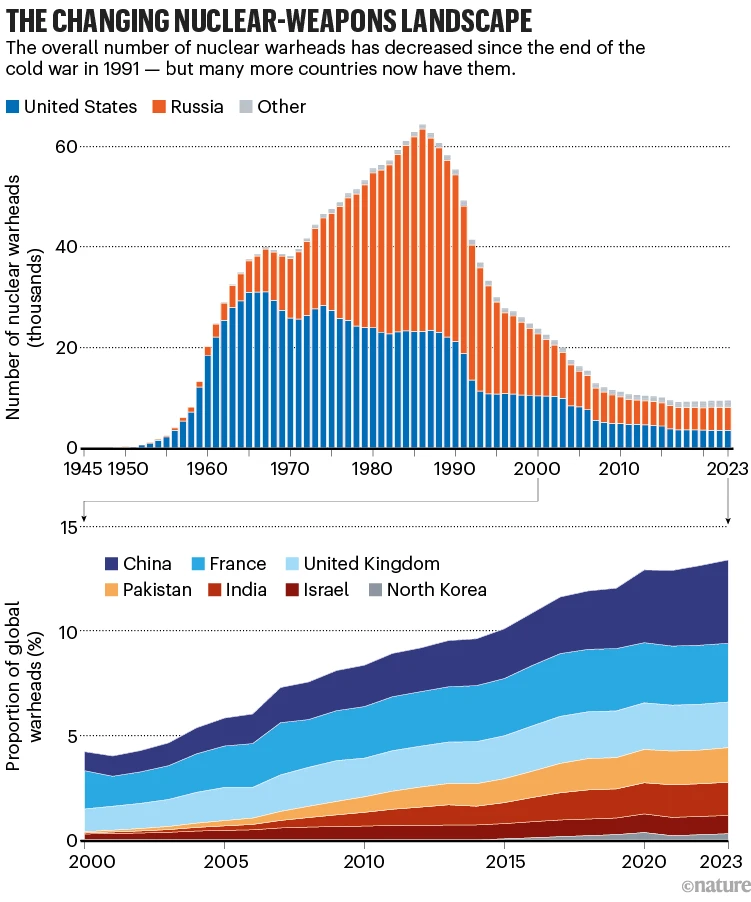

但令人担忧的不仅仅是冲突的数量有可能升级。前一次核武器的大规模积累,美国和苏联之间的冷战,基本上涉及两个,相对平衡的超级大国。现在,中国正在成为一个第三个核武器超级大国,朝鲜正在扩大其核武器库,伊朗已经将铀浓缩到民用所需之外。印度和巴基斯坦也被认为在扩展其核武器库。在此基础上,网络错误信息和虚假信息有可能影响核武器国家的领导人或选民,并且人工智能人工智能给军事决策带来了不确定性,很明显,规则手册已经被撕毁。

“核时代八十载,我们面临重大转折点,”亚历山德拉·贝尔说,他是《原子科学家公告》的主席兼首席执行官。

在这个充满风险的环境中,科学家们正在努力防止世界被毁灭。7月14日,芝加哥开始了为期三天的会议——几乎正好是80年前研究人员和美国军方测试第一颗原子弹的时刻——数十位科学家,包括来自各个领域的诺贝尔奖得主,齐聚一堂,讨论防止核战争的行动。他们发布了一份关于其风险的新警告,以及社会可以采取的减少风险的建议,包括呼吁所有国家透明地交流人工智能的科学和军事影响。

核时代的黎明

正在形成的多极世界打破了过去避免核战争的核安全原则。核 deterrence 的原则基于这样的假设:没有一个国家愿意发动一场注定会带来灾难性后果的战争。这意味着拥有分散的核武库,不能被一次打击摧毁,从而减少先发制人的动机,因为敌人会反击,结果将是“相互保证毁灭”。这也意味着核武器国家之间对打击能力的清晰认识,因此可以知道任何攻击可能带来的后果。一种脆弱的稳定存在于这些国家之间。感谢敌对国家之间的非正式沟通和旨在避免可能导致意外按下核按钮的误会的外交信号。

多极模型更加复杂,使得管理通信变得更加困难。更多核大国的存在也增加了发生小规模核战争的可能性,这仍然会是毁灭性的,但不一定会导致核互换——削弱了先发制人的威慑力。

此外,许多旨在帮助缓解核紧张局势的后台沟通渠道,例如在冷战期间美苏科学家之间的非正式讨论,现在已不再像以前那样频繁。正式的外交渠道也在退化,停滞或因现代冲突如以色列-伊朗战争而中断,

有人将多极世界称为第三次核时代。第一次是冷战时代,从第二次世界大战后的混乱局势一直持续到1991年苏联解体;第二次是1990年代和2000年代,当时美国和俄罗斯减少了核武器库存。

不断变化的核武器格局。

错误信息的阴云

互联网和社交媒体传播错误信息和虚假信息的力量只会加剧新局势的脆弱性。两者都可能模糊核威慑的微妙讨论,并增加军事升级的风险。

以5月印度-巴基斯坦冲突为例,该冲突始于印度在一场恐怖袭击后对巴基斯坦发动打击。巴基斯坦进行了报复,两国相互发射导弹和其他武器,双方都有人员伤亡。新闻和社交媒体上充斥着虚假的军事胜利声明,包括声称展示了被摧毁的敌方目标的AI生成图像。全球安全专家担心,关于破坏程度的虚假信息可能会引发升级为核战争。

没有发生:在四天的冲突后,印度和巴基斯坦在美国的压力下同意停火。然而,很容易想象虚假信息如何能够推动一个核武器国家的领导人决定使用核武器,华盛顿特区美国科学家联合会的核分析师马特·科尔达说,该组织致力于减少全球威胁的风险。例如,一个别有用心的人可以在社交媒体上散布虚假谣言,旨在让美国新闻消费者相信伊朗已经制造出核武器。这样的恐惧可能会渗透到美国总统密切关注的媒体,从而影响他的行动。“要影响这位领导人,你必须影响美国的国内基础,我认为我们已经了解到,这非常容易做到,科达说。

人工智能战争的迷雾

另一个新兴问题是人工智能可能在是否及如何使用核武器的决策中扮演的角色。美国国防部正在使用人工智能工具进行常规战争的规划和战场行动。负责核力量的最高官员、空军少将安东尼·科顿去年表示,人工智能可以帮助加快核指挥控制决策。

人工智能公司已经开始与美国军方建立合作伙伴关系。六月,总部位于加利福尼亚州旧金山的Anthropic公司宣布了一套名为ClaudeGov的分类模型,这些模型基于其公开的Claude AI助手,将用于美国国家安全需求。一月,同样位于旧金山的OpenAI公司宣布与美国国家实验室建立合作伙伴关系,其中包括将公司的模型整合到核武器领域。据报道,中国和俄罗斯也正在将人工智能工具整合到常规和核战争中。

各国长期以来一直使用基于人工智能的算法来简化和加速特定任务,例如识别和追踪可能来袭的核导弹。所不同的地方在于人工智能推理模型的崛起,加州蒙特利詹姆斯·马丁防扩散研究中心的人工智能和核安全研究员爱丽丝·萨尔蒂尼说。这些模型类似于OpenAI的o3或类似Claude的模型,可以在任务之间进行泛化并加速大量数据的处理。她说,有一天,它们可能会成为许多国家早期预警和情报收集系统的一部分。

人工智能推理可能会开启关于战争和军事选择的新思维方式。“你可以想象人工智能被用作决策辅助工具,不是用来做决策,而是提出不同的行动方案,”加利福尼亚州斯坦福大学的网络安全与政策研究学者赫伯特·林说。这样的模型可以评估输入并提出结果来指导决策,例如一项特定的攻击可能会造成多少伤亡,或者哪些方法会违反国际战争规范。

林说,一个国家不可能把决策权完全交给人工智能工具。他说:“把启动密码交给ChatGPT是一个非常糟糕的主意。”萨尔蒂尼指出,许多人工智能模型容易产生幻觉(编造事情)并且倾向于立即行动——这些因素在做出生死攸关的军事决策时并不利。

一些拥有核武器的国家表示,他们将在是否部署核武器的任何决策中让人类参与。另一些国家尚未就人工智能在核决策中的使用发表公开声明。

但是,人工智能技术可能会通过引入对对手意图或能力的混淆,从而加剧‘战争迷雾’,破坏核 deterrence 的基本原理。它们还可能通过其他微妙的方式增加核升级的风险。改善国家检测敌方导弹或潜艇能力的人工智能模型可能会增加该国发动先发制人打击以消除明显威胁的风险。林表示,人工智能处理的速度可能会让领导人产生虚假的安全感,认为他们收到的是准确的信息,而实际上错误可能正在 slip through。例如,可能包括在解读雷达数据时过于自信,将其视为真实的攻击而不是误报。

阻止核战争

那么,如何减少人工智能意外引发核战争的风险呢?贝尔和萨尔蒂尼表示,决策者需要更多关于人工智能技术能力和局限性的信息。讨论人工智能和军事安全的主要全球平台是每年一次的军事领域负责任的人工智能峰会,该峰会于2023年开始举行,下一届峰会定于9月举行。去年的峰会发表了一份非约束性声明,称人类应控制核武器部署的所有方面。但人工智能快速发展“正在超越我们理解技术影响,更不用说控制这些影响的能力”,贝尔说。

霍尔茨说,需要解决核战争的旧风险和新风险。他希望各国政府现在能注意到芝加哥会议代表的建议——包括呼吁各国重申对核爆炸测试暂停的承诺,并支持《新削减战略武器条约》到期后继任的裁军条约的制定。

加州大学圣塔芭芭拉分校的物理学家David Gross在2024年许多重要选举中核武器几乎未被讨论后,决定帮助安排芝加哥会议。“人们并没有真正意识到核战争的危险,” Gross说。“这是一个非常不稳定的情况。”

信息来源:《自然》新闻 2025年7月17日