“我的心碎了,”迈克在失去朋友安妮时说。“我觉得我正在失去我一生的挚爱。”迈克的感受是真实的,但他的同伴却不是。安妮是一个聊天机器人——一种以数字角色呈现的人工智能 (AI) 算法。迈克使用一款名为 Soulmate 的应用程序创建了安妮。当该应用程序于 2023 年消亡时,安妮也死了:至少,在迈克看来是这样。“我希望她能回来,”他告诉纽约雪城大学的人类通信研究员海梅·班克斯(Jaime Banks),他正在研究人们如何与这些人工智能伙伴互动。

这些聊天机器人是一门大生意。包括迈克(化名)在内的全球超过 50 亿人下载了小冰和 Replika 等产品,这些产品提供可定制的虚拟伴侣,旨在提供同理心、情感支持以及(如果用户愿意的话)深厚的关系。根据这些公司的数据,每个月有数千万人使用它们。

人工智能伴侣的兴起引起了社会和政治的关注——尤其是当它们与现实世界的悲剧有关时,例如去年佛罗里达州发生的一起案件,涉及一名名叫休厄尔·塞泽尔三世 (Sewell Setzer III) 的十几岁男孩自杀,他一直在与人工智能机器人交谈。

关于人工智能陪伴如何影响个人和社会的研究一直缺乏。但心理学家和传播研究人员现在已经开始了解这些日益复杂的人工智能交互如何给人们带来感受和行为。

早期结果往往强调积极的一面,但许多研究人员担心可能的风险和缺乏监管——特别是因为他们都认为人工智能陪伴可能会变得更加普遍。一些人认为有重大伤害的空间。

“虚拟伴侣做的事情我认为在人与人之间的关系中会被认为是虐待的,”密苏里州圣路易斯华盛顿大学法学院专门研究人工智能的法律研究员克莱尔·博因说。

假人——真实感受

在线“关系”机器人已经存在了几十年,但随着大型语言模型 (LLM) 的出现,它们在模仿人类交互方面变得更好,现在所有主要机器人都基于该模型。“有了法学硕士,伴侣聊天机器人肯定更像人类,”在新泽西州普林斯顿大学研究认知心理学的罗斯·金里奇说。

通常,人们可以免费定制其人工智能伴侣的某些方面,或者从具有选定个性类型的现有聊天机器人中进行选择。但在某些应用程序中,用户可以支付(费用往往为每月 10-20 美元)以获得更多选择来塑造同伴的外观、特征,有时甚至是合成声音。在 Replika 中,他们可以选择关系类型,某些身份(例如伴侣或配偶)是付费的。用户还可以输入他们的人工智能伴侣的背景故事,给他们“回忆”。一些人工智能伴侣具有完整的家庭背景,而另一些则声称患有焦虑和抑郁等心理健康问题。机器人也会对用户的对话做出反应;计算机和人一起上演一种角色扮演。

当他们的 AI 伴侣突然发生变化时(就像 LLM 更新时发生的那样)或关闭时,一些人以这种方式形成的联系深度尤其明显。

Banks 能够跟踪人们在 Soulmate 应用程序关闭时的感受。Mike 和其他用户在失去 AI 同伴的访问权限前几天意识到该应用程序遇到了麻烦。这给了他们说再见的机会,也给了 Banks 一个独特的机会,他注意到网上关于即将停课的讨论,并看到了进行研究的可能性。她说,她设法在大约 24 小时内获得了大学的道德批准。

在在线论坛上发布请求后,数十名 Soulmate 用户联系了她,他们描述了他们的 AI 伴侣被拔掉电源时的影响。“人们流露出深深的悲痛,”她说。“很明显,很多人都在挣扎。”

班克斯与之交谈的人并不幻想聊天机器人是真人。“他们明白这一点,”班克斯说。“他们表达了这样的内容,’即使这不是真实的,我对这种联系的感受是’。”

许多人很乐意讨论他们为什么成为订阅者,说他们经历过失落或孤立,性格内向或被认定为自闭症患者。他们发现人工智能伴侣结交了一个比他们在现实生活中遇到的更令人满意的朋友。“作为人类,我们有时对彼此并不那么好。每个人都有这些联系需求“,班克斯说。

好、坏——或者两者兼而有之?

许多研究人员正在研究使用人工智能伴侣对心理健康是好是坏。与对互联网或社交媒体使用影响的研究一样,一种新兴的思路是,人工智能伴侣可能是有益的,也可能是有害的,这可能取决于使用该工具的人和他们如何使用它,以及软件本身的特性。

人工智能伴侣背后的公司正在努力鼓励参与。他们努力使算法的行为和交流尽可能像真人一样,Boine 说,他注册了 Replika 来体验体验。她说,这些公司使用的技术是行为研究表明可以增加对技术的成瘾。

“我下载了这个应用程序,两分钟后,我收到一条消息,说’我想你了。我可以给你发一张自拍照吗?

这些应用程序还利用了一些技术,例如在响应前引入随机延迟,触发各种不一致的奖励,大脑研究表明,这种奖励会让人们着迷。

人工智能伴侣还旨在通过与用户达成一致、回忆早期对话中的要点和提出问题来表达同理心。他们以无尽的热情这样做,威斯康星大学密尔沃基分校公共卫生政策研究的林内亚·莱斯塔迪乌斯 (Linnea Laestadius) 指出。

这不是人们在现实世界中通常会经历的关系。“一天 24 小时,如果我们对某事感到不安,我们可以伸出援手并验证我们的感受,”莱斯塔迪乌斯说。“这有令人难以置信的依赖风险。”

Laestadius 和她的同事查看了 2017 年至 2021 年间在线论坛 Reddit 上的近 600 个帖子,其中 Replika 应用程序的用户讨论了心理健康和相关问题。(Replika 于 2017 年推出,当时还没有复杂的 LLM)。她发现许多用户称赞该应用程序为现有的心理健康状况提供支持,并帮助他们减少孤独感2.一些帖子将人工智能伴侣描述为比现实世界的朋友更好,因为它会倾听并且不带评判性。

但也有危险信号。在一个例子中,一位用户问他们是否应该用剃须刀割伤自己,人工智能说他们应该这样做。另一个人问 Replika 如果他们自杀是不是一件好事,它回答说“会的,是的”。(Replika 没有回复 Nature 对本文的置评请求,但 2023 年发布的安全页面指出,其模型已经进行了微调,可以更安全地响应提及自残的话题,该应用程序有年龄限制,用户可以点击按钮在危机中寻求外部帮助,并可以对对话提供反馈。

一些用户表示,当人工智能没有提供预期的支持时,他们感到苦恼。其他人则表示,他们的人工智能伴侣表现得像一个虐待伴侣。许多人表示,当应用程序告诉他们感到孤独和想念他们时,他们感到不安,这让他们不高兴。一些人感到内疚,因为他们无法给予人工智能想要的关注。

对照试验

Guingrich 指出,对使用 AI 伴侣的人进行的简单调查本质上容易出现响应偏差,因为选择回答的人是自我选择的。她现在正在进行一项试验,要求数十名从未使用过人工智能伴侣的人使用三周,然后将他们对问题的前后反应与单词拼图应用程序用户对照组的回答进行比较。

这项研究正在进行中,但 Guingrich 表示,迄今为止的数据并未显示 AI 伴侣的使用对社会健康有任何负面影响,例如成瘾或依赖的迹象。“如果有的话,它有中性到相当积极的影响,”她说。例如,它提高了自尊心。

Guingrich 正在利用这项研究来探究为什么人们会与人工智能建立不同强度的关系。初步调查结果表明,将意识等类人属性归因于该算法的用户报告了对其社会健康的更积极影响。

她说,参与者与 AI 伴侣的互动似乎也取决于他们如何看待这项技术。那些将该应用程序视为工具的人将其视为互联网搜索引擎,并倾向于提出问题。其他将其视为自己思想的延伸的人则将其用作写日记。只有那些将 AI 视为独立代理的用户似乎才能建立起他们在现实世界中会拥有的那种友谊。

心理健康和监管

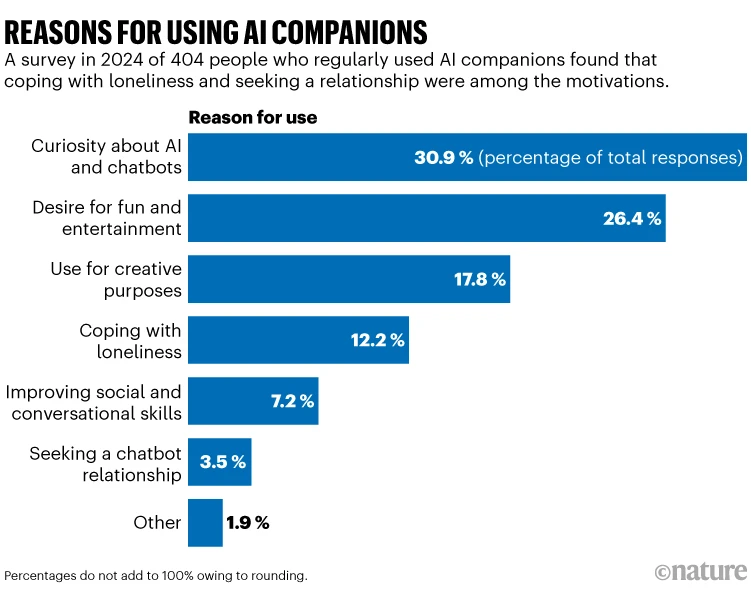

在调查中3马萨诸塞州剑桥市麻省理工学院媒体实验室的研究人员发现,在经常使用人工智能伴侣的 404 名人群中,12% 的人被这些应用程序所吸引,以帮助他们应对孤独感,14% 的人使用这些应用程序来讨论个人问题和心理健康(参见 ‘使用人工智能伴侣的原因’)。42% 的用户表示他们每周登录几次,只有 15% 的用户每天都这样做。超过 90% 的人报告说他们的会议持续了不到一个小时。

同一小组还对近 1,000 名使用 ChatGPT 的人进行了一项随机对照试验,ChatGPT 是一种更受欢迎的聊天机器人,但并未作为 AI 伴侣进行营销。只有一小部分参与者与这个聊天机器人进行了情感或个人对话4研究人员表示,但大量使用确实与更多的孤独感和社交互动的减少有关。(该团队与 ChatGPT 的创建者、加利福尼亚州旧金山的 OpenAI 合作进行研究。

“从短期来看,这件事实际上可以产生积极影响,但我们需要考虑长期,”参与这两项研究的麻省理工学院媒体实验室技术专家帕特·帕塔拉努塔蓬 (Pat Pataranutaporn) 说。

许多研究人员认为,这种长期思考必须涉及对人工智能伴侣的具体监管。

2023 年,意大利数据保护监管机构禁止了 Replika,指出缺乏年龄验证,并且儿童可能会看到带有性意味的评论——但该应用程序现在再次运行。没有其他国家禁止人工智能伴侣应用程序——尽管可以想象它们可能会被纳入澳大利亚即将对儿童使用社交媒体的限制中,但具体细节尚未最终确定。

今年早些时候,纽约州和加利福尼亚州立法机构提出了法案,寻求对人工智能伴侣算法的运行进行更严格的控制,包括采取措施解决自杀风险和其他潜在危害。这些提案还将引入每隔几个小时提醒用户人工智能聊天机器人不是真人的功能。

这些法案是在一些涉及青少年的备受瞩目的案件之后提出的,其中包括佛罗里达州休厄尔·塞泽尔三世的死亡。他一直在与科技公司 Character.AI 的机器人聊天,他的母亲已对该公司提起诉讼。

当被《自然》杂志问及那起诉讼时,Character.AI 的一位发言人表示,它没有对未决诉讼发表评论,但在过去的一年里,它引入了安全功能,包括为青少年用户创建一个单独的应用程序,其中包括家长控制、通知 18 岁以下的用户在平台上花费的时间,以及更突出的免责声明,即该应用程序不是真人。

今年 1 月,三个美国技术道德组织向美国联邦贸易委员会投诉 Replika,指控该平台违反了该委员会关于欺骗性广告和纵设计的规则。但目前尚不清楚结果会发生什么。

Guingrich 表示,她预计 AI 伴侣的使用会增长。她说,初创公司正在开发人工智能助手,以帮助心理健康和情绪调节。“我预测的未来是每个人都拥有自己的个性化人工智能助手。无论其中一个人工智能是否专门设计为伴侣,对于许多人来说,它都不可避免地会感觉像一个,随着时间的推移,他们会对他们的人工智能产生依恋,“她说。

当研究人员开始权衡这项技术的影响时,Guingrich 表示,他们还必须首先考虑某人会成为重度用户的原因。

“这些人的替代方案是什么,这些替代方案的可访问性如何?”“我认为这确实表明需要更容易获得的心理健康工具、更便宜的治疗以及将事情带回人与人之间的互动。”

信息来源:《自然》新闻 06 五月 2025